TE

TE

konq

Gast

Danke für die Tipps.

<< Das Board ist okay, wenn du auch gut übertakten willst. Ansonsten reicht an sich auch eines für 80-90€.

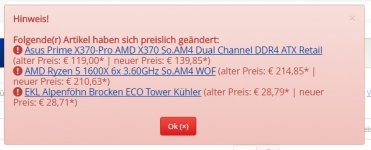

Mir ging es hierbei um AM4 und um den X370 Chipsatz und ASUS (weil langlebig). Das ist dann von diesen Kriterien her das günstigste.

<< Der brocken Eco ist gut, aber falls du mal RICHTIG übertakten willst ein wenig zu "schwach".

Mag nicht übertakten, danke aber für den Einwand..gif)

Der 1600X ist ja schon ein bisschen ab Werk "übertaktet".

<< @konq: beim RAM musst du mal schauen, ob das Dual RANK hat. Ansonsten macht es keinerlei Sinn, so teures RAM zu holen - da wäre effektiv am Ende Dual RANK RAM mit "nur" 2400MHz sogar schneller, und das G.Skill kannst du vlt auch gar nicht mit 3200, sondern mit nur 2666Mhz betreiben.

Oh mist ich wusste das wird wieder kompliziert.

Also ein "Crucial Ballistix Sport LT rot DIMM Kit 16GB, DDR4-2400, CL16-16-16 (BLS2C8G4D240FSE)" für 140 Euro tuts auch?

Aber warum genau? Das Board, der CPU unterstützen doch DDR4-3200. Was genau hält ihn davon ab, das zu nutzen? Wirklich die Anzahl der chips auf den Speicherbänken? Ich hab 10 Euro draufgelegt um von CL16 auf CL15 zu kommen. Leider kann ich auf der Seite nicht sehen, ob das Ding dual rank hat. Nach ein paar Suchen hat der das wohl nicht. Dual Rank für 2x16 GB Module gibts ab 360 Euro...?? Ein Einzelner 16 GB Riegel kostet 190 Euro...

Ok, was soll ich nehmen was ist am preis-leistungs - Besten?

<< Das Board ist okay, wenn du auch gut übertakten willst. Ansonsten reicht an sich auch eines für 80-90€.

Mir ging es hierbei um AM4 und um den X370 Chipsatz und ASUS (weil langlebig). Das ist dann von diesen Kriterien her das günstigste.

<< Der brocken Eco ist gut, aber falls du mal RICHTIG übertakten willst ein wenig zu "schwach".

Mag nicht übertakten, danke aber für den Einwand.

.gif)

Der 1600X ist ja schon ein bisschen ab Werk "übertaktet".

<< @konq: beim RAM musst du mal schauen, ob das Dual RANK hat. Ansonsten macht es keinerlei Sinn, so teures RAM zu holen - da wäre effektiv am Ende Dual RANK RAM mit "nur" 2400MHz sogar schneller, und das G.Skill kannst du vlt auch gar nicht mit 3200, sondern mit nur 2666Mhz betreiben.

Oh mist ich wusste das wird wieder kompliziert.

Also ein "Crucial Ballistix Sport LT rot DIMM Kit 16GB, DDR4-2400, CL16-16-16 (BLS2C8G4D240FSE)" für 140 Euro tuts auch?

Aber warum genau? Das Board, der CPU unterstützen doch DDR4-3200. Was genau hält ihn davon ab, das zu nutzen? Wirklich die Anzahl der chips auf den Speicherbänken? Ich hab 10 Euro draufgelegt um von CL16 auf CL15 zu kommen. Leider kann ich auf der Seite nicht sehen, ob das Ding dual rank hat. Nach ein paar Suchen hat der das wohl nicht. Dual Rank für 2x16 GB Module gibts ab 360 Euro...?? Ein Einzelner 16 GB Riegel kostet 190 Euro...

Ok, was soll ich nehmen was ist am preis-leistungs - Besten?