AntonioFunes

Autor

- Mitglied seit

- 29.09.2010

- Beiträge

- 950

- Reaktionspunkte

- 109

Jetzt ist Deine Meinung zu Nvidia: Raytracing teils auch ohne RTX-Grafikkarte gefragt.

Bitte beachtet: Der Kommentarbereich wird gemäß der Forenregeln moderiert.

Zum Artikel: Nvidia: Raytracing teils auch ohne RTX-Grafikkarte

Zum Artikel: Nvidia: Raytracing teils auch ohne RTX-Grafikkarte

Bitte beachtet: Der Kommentarbereich wird gemäß der Forenregeln moderiert.

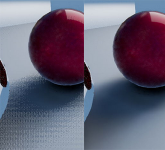

.gif) Dass eine neue Technik Zeit braucht, um sich richtig durchzusetzen, ist klar. Klar ist auch, dass Raytracing noch nicht optimal eingesetzt ist und es noch Luft nach oben gibt.

Dass eine neue Technik Zeit braucht, um sich richtig durchzusetzen, ist klar. Klar ist auch, dass Raytracing noch nicht optimal eingesetzt ist und es noch Luft nach oben gibt.